AI 분야에서 대형 언어 모델(LLM)의 성능 향상과 윤리적 적용이 화두로 떠오르고 있다. arXiv를 비롯한 학술 플랫폼과 주간 ML 뉴스 큐레이션에서 최근 공개된 논문 및 기술 보고서들은 다중 모달 이해, 추론 한계, 그리고 학제 간 윤리적 AI 응용을 깊이 있게 다루고 있다. 특히 LG AI Research의 EXAONE 3.0과 Apple의 최신 기초 언어 모델 기술 보고서가 주목받고 있다.

LG AI Research EXAONE 3.0: 한국어·영어 최적화된 오픈소스 고급 LLM

LG AI Research가 개발한 EXAONE 3.0 (7.8B 파라미터 instruction-tuned 모델)은 지시 튜닝(instruction tuning)을 통해 다중 모달 이해(multimodal understanding)와 복잡한 추론(reasoning) 능력을 강조한 오픈 모델이다. 2024년 8월 arXiv에 처음 공개된 이 논문(최근 2026년 1월 개정)은 영어와 한국어에서 우수한 성능을 보이며, 일반 태스크와 고난도 추론 벤치마크에서 경쟁력 있는 결과를 입증했다.

- 주요 특징: bilingual(영어·한국어) 지원, instruction-following 강화, multimodal 기능 통합.

- 강점: 한국어 태스크에서 특히 탁월하며, 오픈소스로 공개되어 연구자와 개발자들이 자유롭게 활용 가능.

- 의의: 국내 AI 연구의 글로벌 경쟁력을 보여주는 사례로, Hugging Face 등 플랫폼에서 다운로드 가능.

(출처: arXiv - https://arxiv.org/abs/2408.03541)

Apple Intelligence Foundation Models: 훈련 과정과 최적화 상세 공개

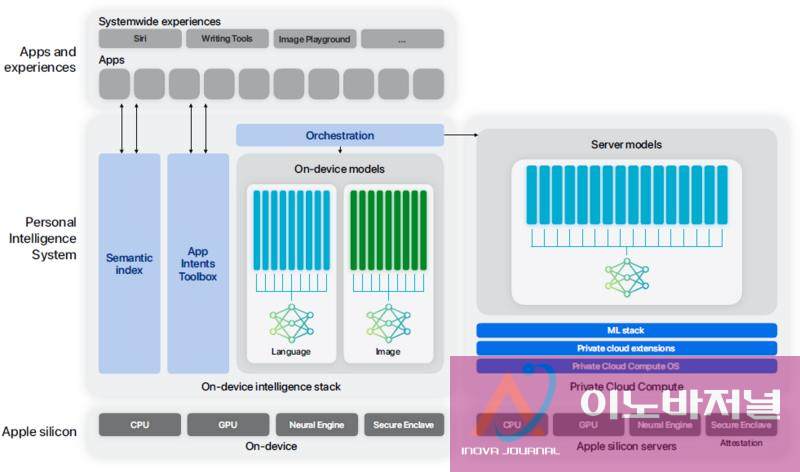

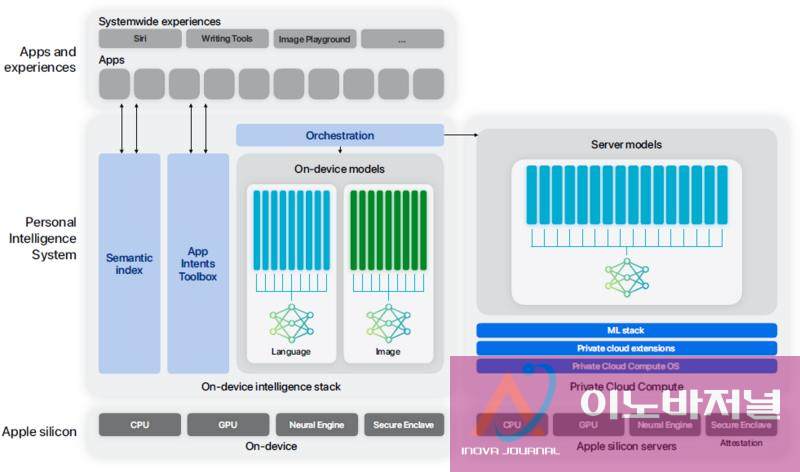

Apple은 2025년 7월 기술 보고서(Apple Intelligence Foundation Language Models Tech Report 2025)를 통해 온디바이스 및 서버용 기초 언어 모델의 상세한 훈련 프로세스를 공개했다. 이 보고서는 모델 아키텍처, 데이터 소스, 최적화 기법을 투명하게 설명하며, 프라이버시 중심의 AI 개발 철학을 드러낸다.

- 아키텍처: ~3B 파라미터 온디바이스 모델(Apple Silicon 최적화, KV-cache sharing, 2-bit quantization-aware training)과 PT-MoE(Parallel-Track Mixture-of-Experts) 기반 서버 모델(트랙 병렬 처리, interleaved attention).

- 데이터 소스: 대규모 다국어·멀티모달 웹 크롤링, 라이선스 코퍼스, 합성 데이터 사용.

- 훈련 및 최적화: 지도 미세 조정, 강화 학습, Swift-centric guided generation, LoRA fine-tuning, Private Cloud Compute를 통한 프라이버시 보호.

- 특징: 이미지 이해, 도구 호출 지원, 다국어 확장성 강화. 오픈 베이스라인 대비 동등하거나 우수한 벤치마크 성능.

Apple의 이 보고서는 AI 모델 개발의 '블랙박스' 문제를 해소하며, 산업계에 투명한 훈련 표준을 제시한다.

(출처: Apple Machine Learning Research - https://machinelearning.apple.com/research/apple-foundation-models-tech-report-2025)

medium.com

medium.comOn-device AI - Apple Intelligence: Architecture of Apple ...

LLM 체인-오브-소트(CoT) 추론의 한계와 윤리적 AI 응용 논의 활발

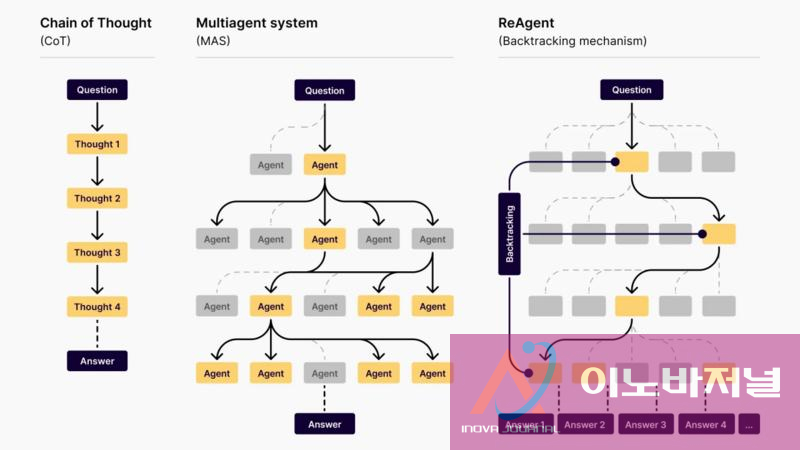

주간 ML 뉴스 큐레이션(dair-ai/ML-Papers-of-the-Week 등)에서 LLM의 Chain-of-Thought (CoT) 추론 한계에 대한 논의가 이어지고 있다. 최근 논문들은 CoT가 패턴 기반 인컨텍스트 학습(ICL)에서 직접 답변보다 낮은 성능을 보이며, '맥락 거리 저주(Contextual Distance Curse)'와 패턴 추론 실패를 주요 원인으로 지적한다.

- 주요 발견: CoT는 토큰 비용이 40배 증가함에도 불구하고, symbolic 태스크에서 특히 약세. 오버싱킹(overthinking)이나 언더싱킹(underthinking) 현상으로 효율성 저하.

- 의의: CoT의 보편적 우수성을 재고하게 하며, 적응형 추론 전략 개발 필요성 강조.

또한 학제 간 윤리적 AI 응용 논문들이 증가하고 있다. 의료·사회·혁신 분야에서 AI의 공정성, 투명성, 환자 동의, 감정적 의존성, misalignment 위험 등이 다뤄지며, socioaffective alignment와 감사 프레임워크를 제안한다.

AI 연구의 미래 방향성

이러한 최근 연구들은 LLM의 성능 향상뿐만 아니라 한계 인식과 윤리적 책임을 강조한다. EXAONE 3.0처럼 오픈소스 모델 확대와 Apple의 투명한 보고서 공개는 AI 생태계의 성숙도를 보여준다. 2026년 AI 개발은 효율성, 프라이버시, 공정성을 동시에 추구하는 방향으로 나아갈 전망이다.

이노바저널(AXINOVA 평생교육원 AI 교육 연구소)은 최첨단 AI 연구 트렌드를 지속적으로 분석하며, 독자 여러분의 혁신을 응원합니다.

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

2025년 말, AI 분야에서 주요 기업들의 연이은 발표가 이어지며 기술 발전의 속도가 가속화되고 있다. xAI의 로보틱스용 물리 세계 이해 모델 개발, OpenAI의 GPT-5 시리즈 업데이트, 그리고 Hugging Face의 맞춤형 NLP 오픈소스 모델 출시가 그 중심에 있다. 이러한 발전은 로보틱스, 자연어 처리, 콘텐츠 생성 등 다양한 영역에서 실용적 적용을 촉진할 ...

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

2025년 말, AI 분야에서 주요 기업들의 연이은 발표가 이어지며 기술 발전의 속도가 가속화되고 있다. xAI의 로보틱스용 물리 세계 이해 모델 개발, OpenAI의 GPT-5 시리즈 업데이트, 그리고 Hugging Face의 맞춤형 NLP 오픈소스 모델 출시가 그 중심에 있다. 이러한 발전은 로보틱스, 자연어 처리, 콘텐츠 생성 등 다양한 영역에서 실용적 적용을 촉진할 ...

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

목록

목록