작성자 : 최득진 박사

[법학박사 | 전 대학교수 | 평생교육사 | 사회분석 전문가 | 교육사회 전문가 | 외국인을 위한 한국어 교원 | 상담심리 전문가 | Chat GPT AI 1급 지도사 | MSC 마음챙김 국제 지도자 | AXINOVA R&D 원장 | AI 리서치 컨설턴트]

인포그래픽=기사 내용을 기반하여 AI로 생성한 것입니다.

인포그래픽=기사 내용을 기반하여 AI로 생성한 것입니다.

GPT-4.1 Turbo와 정면승부… 내부 아키텍처와 시장 파장 분석

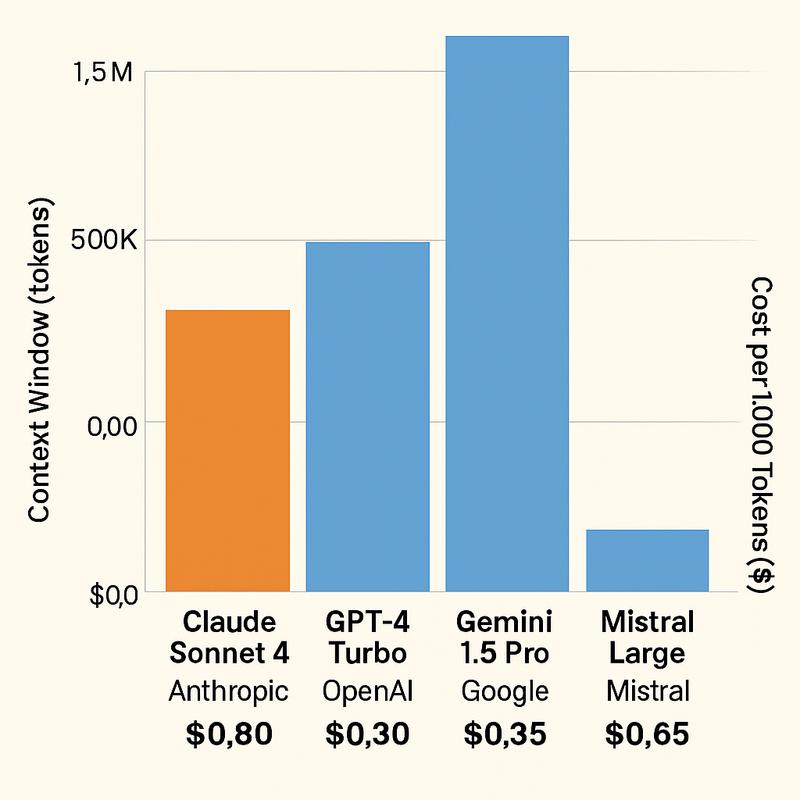

AI 모델 경쟁에서 ‘맥락 창(Context Window)’은 성능을 가늠하는 핵심 지표다. 맥락 창이란 모델이 한 번에 처리·참조할 수 있는 입력 데이터의 범위를 뜻한다. 이 크기가 클수록 AI는 긴 문서나 복잡한 코드베이스를 분할 없이 이해·분석할 수 있다.

최근 Anthropic이 발표한 Claude Sonnet 4의 업그레이드는 이 영역에서 대담한 도약이다. 이번 개선으로 컨텍스트 창은 100만 토큰에 도달했다. 토큰을 페이지 수로 환산하면 약 2,500쪽, 코드 기준으로는 7만5천~11만 줄에 해당한다. 이는 GPT-4.1 Turbo가 제공하는 100만 토큰 범위와 어깨를 나란히 하는 수준이다.

■ 내부 작동 원리 — ‘스트리밍·압축’ 기반의 메모리 확장

업계 분석에 따르면, Claude Sonnet 4는 압축 인코딩(Compressed Embedding)과 스트리밍 어텐션(Streaming Attention) 기법을 결합해 메모리 한계를 극복했다.

압축 인코딩: 입력 데이터를 의미 단위로 묶어 벡터 공간에서 고밀도 표현으로 변환, 불필요한 토큰 낭비 최소화

스트리밍 어텐션: 전체 데이터를 순차적으로 처리하되, 중요도가 높은 컨텍스트는 장기 메모리에 유지하고 비핵심 컨텍스트는 단기 캐시로 이동

이 구조 덕분에 모델은 전체 데이터셋을 ‘한꺼번에 보는 듯한’ 효과를 내면서도 계산 복잡도와 비용을 억제할 수 있다.

■ 경쟁사 비교

OpenAI GPT-4.1 Turbo: 동일한 100만 토큰 컨텍스트 지원. 다만 코드 해석·리팩터링에서 GPT 계열이 여전히 강점을 보인다.

Google Gemini 1.5 Pro: 200만 토큰까지 처리 가능하지만, 고정밀 코드 리뷰 성능은 Claude보다 일관성이 떨어진다는 평가.

Mistral Large: 64K~128K 수준의 맥락 창 제공, 속도·비용 최적화에 집중하는 전략.

Anthropic은 “컨텍스트 확장은 단순한 숫자 경쟁이 아니라, 모델의 이해 능력과 사용자 워크플로우 효율을 극대화하는 과정”이라고 강조한다.

■ 산업 적용과 파급 효과

법률: 대형 계약서, 소송 문서 전체를 한 세션에서 검토 및 요약

소프트웨어 개발: 수십만 줄 규모의 리포지토리를 통째로 분석·리팩터링

데이터 분석: 장기간 축적된 로그·리포트에서 추세 탐지

이러한 활용은 인력 투입과 시간을 절감하는 동시에, ‘한 번의 AI 호출로 프로젝트 전체를 조망하는’ 방식의 업무 혁신을 촉발할 가능성이 크다.

전문가 견해:

“100만 토큰은 단순한 확장이 아니다. 이는 AI가 ‘문제의 전체 지형’을 인식하고 전략적으로 접근할 수 있는 수준의 기억력을 갖췄다는 뜻이다.” — AI 리서치 컨설턴트, 최득진 박사

다음 단계에서 Anthropic이 고정밀 검색·추론 기능과 결합하면, 맥락 창 확장은 단순한 텍스트 이해를 넘어 ‘장기 기억 기반의 AGI 전환’의 징검다리가 될 수 있다는 전망이 나온다.

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

목록

목록