- KAIST 박종세 교수팀, 메모리 병목 해결한 고성능 NPU로 세계 권위 ‘ISCA 2025’ 논문 채택

자료=논문 483쪽 갈무리

자료=논문 483쪽 갈무리

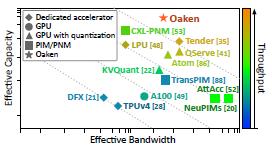

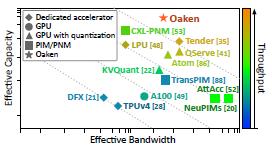

♦ 다양한 AI 추론용 컴퓨팅 가속기들을 성능 비교한 산점도 그래프 설명

X축은 "효과적인 대역폭"(Effective Bandwidth),

Y축은 "효과적인 용량"(Effective Capacity)을 나타내며,

색상으로 표현된 색상 그래디언트는 추론 처리량(Throughput)을 의미

- 그래프 상에서 Oaken은 대역폭과 용량 모두에서 높은 위치를 차지하며, 높은 처리량도 시각적으로 확인된다.

이 이미지 전체는 KAIST가 개발한 생성형 AI 추론 최적화 NPU 기술의 성능적 우월성을 시각적으로 나타낸 비교 자료로 볼 수 있다(편집자 주).

2025년 7월 4일, 한국과학기술원(KAIST) 전산학부 박종세 교수 연구팀이 개발한 신경망처리장치(NPU, Neural Processing Unit)가 세계 최고 수준의 생성형 인공지능(GenAI) 추론 성능 향상을 이끌 기술로 주목받고 있다. 해당 기술은 기존 고성능 GPU 대비 44% 낮은 전력 소비에도 불구하고, 챗GPT와 같은 대형 언어모델(LLM)의 추론 속도를 평균 60% 이상 개선한 성과를 이뤘다.

해당 연구는 전기및전자공학부 김주영 교수의 창업기업 ㈜하이퍼엑셀과의 산학협력을 통해 공동 개발되었으며, 컴퓨터 아키텍처 분야 세계 최고 권위 학술대회인 ‘국제 컴퓨터구조 심포지엄(ISCA 2025)’에 채택됐다. 이번 ISCA에서는 총 570편의 논문 중 127편(채택률 22.7%)만이 채택되었으며, 박종세 교수팀의 논문은 기술적 독창성과 실용성 측면에서 두각을 나타냈다.

NPU 기반 기술의 혁신: 고성능 + 저전력 = AI 인프라 대전환

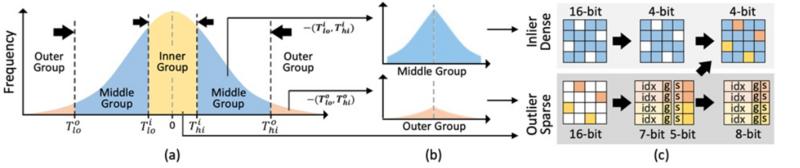

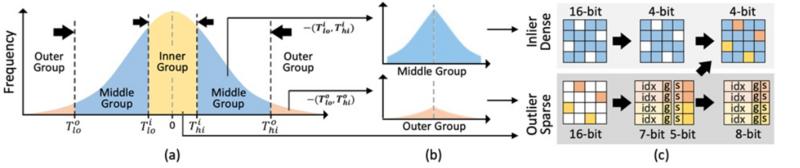

연구팀이 개발한 핵심 기술은 ‘KV 캐시(Key-Value Cache) 양자화’ 알고리즘에 있다. 이는 챗GPT 등 생성형 AI가 텍스트를 생성하는 과정에서 가장 많은 메모리를 사용하는 KV 캐시의 데이터를 32비트 → 4비트로 줄이는 기술로, 데이터 크기를 1/8 수준으로 낮춘다. 덕분에 메모리 병목 현상을 완화하면서도 정확도를 유지할 수 있다.

자료=본 연구 논문(488쪽 참조)에서 설계한 KV 캐시 양자화 알고리즘의 개요도 ♦ 도식에서는 KV 캐시 양자화 과정을 통해 실제 메모리 사용량이 급감하고, GPU 대비 성능 효율이 향상되는 모습이 그래픽으로 제시되고 있다(편집자 주).

자료=본 연구 논문(488쪽 참조)에서 설계한 KV 캐시 양자화 알고리즘의 개요도 ♦ 도식에서는 KV 캐시 양자화 과정을 통해 실제 메모리 사용량이 급감하고, GPU 대비 성능 효율이 향상되는 모습이 그래픽으로 제시되고 있다(편집자 주).

또한 연구팀은 이 양자화 알고리즘을 적용할 수 있도록 NPU 내부의 메모리 인터페이스 및 하드웨어 아키텍처를 통합 설계하였다. 이 아키텍처는 GPU 없이도 고성능 AI 추론 환경을 구성할 수 있게 해 주며, 클라우드 기업 입장에서 장비 비용과 전력 비용을 동시에 절감할 수 있다는 점에서 주목된다.

국제적 경쟁력: ‘AI 추론 가속기’ 시대의 돌파구

연구 성과는 단순한 기술 혁신을 넘어 산업적 응용 가능성에서도 높은 평가를 받는다. 특히, AI 인프라 구축에 있어 가장 큰 비용 요소로 꼽히는 GPU 구매를 대체할 수 있어, 마이크로소프트(MS), 구글, 오픈AI 등 초거대 AI 기업들도 높은 관심을 보일 수 있는 기술이다.

박종세 교수는 “이 기술은 생성형 AI에 특화된 고성능·저전력 인프라의 가능성을 입증한 것”이라며, “향후 에이전틱 AI(Agentic AI)와 같은 실행형 AI 환경에서도 중요한 역할을 할 수 있을 것”이라고 밝혔다.

연구 제1저자는 KAIST 김민수 박사과정과 ㈜하이퍼엑셀 홍성민 박사이며, 논문 제목은 “Oaken: Fast and Efficient LLM Serving with Online-Offline Hybrid KV Cache Quantization”이다.

→ 📄 DOI 링크: https://doi.org/10.1145/3695053.3731019

🎯 기술적 의의 요약

구분 | 내용 |

|---|

📌 핵심 기술 | KV 캐시 양자화 및 이를 최적화한 NPU 아키텍처 설계 |

🚀 성능 개선 | GPU 대비 60% 이상 추론 성능 향상, 44% 전력 절감 |

💰 경제성 | 적은 수의 NPU로 AI 클라우드 인프라 구성 가능 → GPU 구매비용 절감 |

🌐 발표 학회 | ISCA 2025 (국제 컴퓨터구조 심포지엄) |

👨🔬 주요 연구진 | 박종세 교수, 김민수 박사과정, 홍성민 박사 (하이퍼엑셀) |

🏛️ 공동 기관 | KAIST 전산학부, 전기및전자공학부, (주)하이퍼엑셀 |

🧪 지원 사업 | 한국연구재단, IITP, AI반도체대학원지원사업 |

이 연구는 AI 추론 연산의 효율성과 실용성을 모두 확보한 기술로, 글로벌 AI 인프라 경쟁에서 한국이 기술 주도권을 확보할 수 있는 토대를 마련했다는 점에서 학계와 산업계 모두의 이목을 집중시키고 있다.(보도자료: KAIST 누리집 뉴스 참고)

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

2025년 말, AI 분야에서 주요 기업들의 연이은 발표가 이어지며 기술 발전의 속도가 가속화되고 있다. xAI의 로보틱스용 물리 세계 이해 모델 개발, OpenAI의 GPT-5 시리즈 업데이트, 그리고 Hugging Face의 맞춤형 NLP 오픈소스 모델 출시가 그 중심에 있다. 이러한 발전은 로보틱스, 자연어 처리, 콘텐츠 생성 등 다양한 영역에서 실용적 적용을 촉진할 ...

AI 혁신 물결: xAI의 세계 모델, OpenAI GPT-5 업데이트, Hugging Face 오픈소스 NLP 모델 출시

2025년 말, AI 분야에서 주요 기업들의 연이은 발표가 이어지며 기술 발전의 속도가 가속화되고 있다. xAI의 로보틱스용 물리 세계 이해 모델 개발, OpenAI의 GPT-5 시리즈 업데이트, 그리고 Hugging Face의 맞춤형 NLP 오픈소스 모델 출시가 그 중심에 있다. 이러한 발전은 로보틱스, 자연어 처리, 콘텐츠 생성 등 다양한 영역에서 실용적 적용을 촉진할 ...

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

서울국제조각페스타 2026, 코엑스서 예술과 기업의 만남 성황

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

[손현식 칼럼] 270만 외국인 시대, ‘함께 사는 법’은 배운 적이 없다

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

할리우드 배우노조, 스튜디오 측에 새 반대 제안 테이블에 올리다

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

하나님의 축복 속에서 시작된 사랑… 특별한 결혼의 여정

목록

목록